Le 29 février 2009, Google abandonne la marque déposée TrustRank, mais vient de déposer un brevet le 13 octobre 2009 qui s’intitule « Search Result Ranking Based On Trust ».

Le 29 février 2009, Google abandonne la marque déposée TrustRank, mais vient de déposer un brevet le 13 octobre 2009 qui s’intitule « Search Result Ranking Based On Trust ».

Cette nouvelle notion s’éloigne encore plus du mythe véhiculé sur Internet à propos d’un TrustRank pour les sites de confiance. Soudain, nous sommes en face de la réalité d’un PersonRank qui évalue le profil d’un utilisateur et prend en compte ses annotations à propos des pages Web.

C’est en lisant l’article de l’excellent Bill Slawski que je prends connaissance de ce nouveau développement, mais tout d’abord un bref état des lieux s’impose pour poser des bases saines à propos du TrustRank.

Comme j’expliquais il y a peu dans mon article sur le mythe du TrustRank, la plupart des gens font référence à cette notion par rapport à une étude qui n’a rien à voir avec Google puisqu’elle est associée avec Yahoo!. Par ailleurs, Matt Cutts confirmait que le TrustRank était seulement un filtre antiphising qui n’était pas lié à l’étude en question. Explication par l’intéressé dans la vidéo suivante.

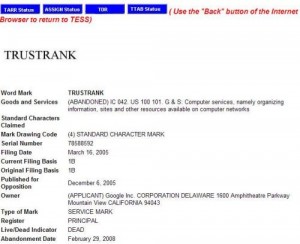

Abandon de la marque TrustRank

Le 29 février 2009, Google abandonne le dépôt de marque TrustRank comme démontre l’aperçu de gauche, mais un dépôt de brevet au 13 octobre 2009 indique une évolution intéressante pour la recherche d’information, tout en s’éloignant encore plus du mythe qui reste bien profondément marqué chez les webmasters et référenceurs.

Le 29 février 2009, Google abandonne le dépôt de marque TrustRank comme démontre l’aperçu de gauche, mais un dépôt de brevet au 13 octobre 2009 indique une évolution intéressante pour la recherche d’information, tout en s’éloignant encore plus du mythe qui reste bien profondément marqué chez les webmasters et référenceurs.

Google met au point un système innovant de classement des pages qui prend en compte les annotations des utilisateurs en tant que vote de confiance. Bien entendu, on pense tout de suite à SideWiki qui vient d’être lancé et qui permet effectivement de poser des commentaires à propos d’une page Web. Ce qui est intriguant est qu’il n’y a pas de référence à Sidewiki dans le brevet déposé par Google, mais par contre Slawski note une ressemblance avec l’étude élaborée par l’ingénieur Google, Ramanathan Guha, alors qu’il était chez IBM. Puisque c »est Guah qui a déposé le brevet au nom de Google, il est clair que son travail actuel est une prolongation du travail effectué chez IBM dont l’étude en question peut nous indiquer des pistes pour mieux comprendre ce qui se trame chez Google.

Le brevet du Trust Rank

Search result ranking based on trust

Invented by Ramanathan Guha

Assigned to Google

US Patent 7,603,350

Granted October 13, 2009

Filed: May 9, 2006

L’extrait du brevet se traduit comme suit :

Un moteur de recherche procure des résultats qui sont classés en fonction d’une mesure de confiance associée avec des entités présentées sous forme de notes au sein des résultats de recherche. Un moteur de recherche reçoit une requête et sélectionne les documents pertinents pour cette requête.

Le moteur de recherche détermine également les notes associées avec les documents sélectionnés, ainsi que les niveaux de confiance des entités qui procurent les notes. Les niveaux de confiance sont utilisés pour déterminer le facteur de confiance des documents respectifs. Les facteurs de confiance sont également utilisés pour ajuster le score de récupération de l’information des documents. Les résultats de recherche sont ainsi classés sur la base d’information du score ajusté.

C’est donc la notion de pertinence des notes posées par des utilisateurs qualifiés qui ressort. Le challenge consiste à récupérer et analyser ces notes, mais surtout de cerner qui sont les utilisateurs dont les commentaires portent un certain poids.

Au-delà de SideWiki, il est possible d’annoter des pages lorsque nous sommes connectés à notre compte Google, ainsi que les discussions Google Wave, mais il existe également de nombreux supports possibles pour dénicher des notes d’utilisateurs. Pour cela, il faut que Google sorte de son carcan pour explorer les commentaires de blogs, discussions Wiki, etc.

Mais d’abord, il faut s’attacher à savoir comment cerner le profil d’un internaute…

Évaluer l’utilisateur humain, le PersonRank

Recentrer le classement des résultats de recherche autour de l’utilisateur a toujours été quelque chose que je défends. Selon moi, Google n’a pas attendu ce brevet pour évaluer le profil d’un utilisateur et s’en servir pour mieux classer les pages. L’élément clef pour agir de la sorte est la Google Toolbar qui détermine facilement un profil d’internaute puisqu’elle analyse la navigation et l’utilisation des pages Web. Maintenant, grâce à d’autres supports comme SideWiki et Google Wave, le moteur de recherche dispose en interne de puissants outils pour évaluer encore plus précisément le profil d’un internaute.

Ainsi, pendant que les webmasters focalisaient sur le PageRank, vote d’une page Web vers une autre, Google travaillait pour recentrer sa manière de classement sur le vote de l’internaute. C’est d’ailleurs assez fascinant d’observer les implications du partenariat avec Twitter, notamment pour mieux cerner le Web sémantique.

La prochaine rumeur qui va parcourir le milieu du référencement sera le PersonRank. Vous voulez qu’on lance un buzz ?

Halte au mythe du TrustRank. Vive le nouveau mythe du PersonRank

La légende urbaine du TrustRank semble bien établie au sein de la communauté du référencement et au-delà. Pour les croyants en ce mythe, Google applique un classement en fonction du niveau d’autorité du site et conséquemment sur le vote qu’il va envoyer au travers d’un lien (backlink). Cette notion existe évidemment dans l’algo, mais ce n’est pas du tout lié au TrustRank comme expliqué précédemment et ce nouveau développement nous éloigne encore plus de ce fantasme à moitié abouti.

Il existe bien un Trust Rank ou classement de confiance, mais il est centré autour de l’internaute ( PersonRank ), plutôt que sur les sites Web. C’est d’ailleurs logique puisque Google est toujours aussi incapable de combattre efficacement le spam. Se tourner vers la pertinence du vote humain est bien plus fiable que laisser l’algorithme s’embourber avec ce classement des pages Web qui reste perfectible.

Je ne crois pas que Google trafique manuellement les résultats de recherche. Les suspicions liées à un déclassement des résultats naturels après avoir arrêté de payer des liens sponsorisés Adwords ne tient pas debout et n’a jamais été formellement prouvé. Mis à part le blacklistage d’un site qui est effectué manuellement, c’est bien sur une base d’algorithmes par couches que le moteur fonctionne. La subtilité actuelle consiste à récupérer un élément humain (vote de confiance) pour l’intégrer dans ce classement automatique.

Google souhaite rendre ses résultats de recherche meilleurs grâce au vote de confiance par l’utilisateur qualifié. Nous entrons dans l’ère du Social Media Optimization (SMO) avec un enjeu majeur pour les sociétés qui peinent véritablement à trouver la manière de pénétrer le Web communautaire. Seulement, le partenariat annoncé avec Twitter marque évidemment une démarche dans ce sens, mais je ne sais pas si l’outil de micro-blogging est vraiment le bon choix pour améliorer la pertinence.

Pour terminer, certains sont outrés de ma réaction par rapport au rejet de Google Wave, mais il faut comprendre que je sais depuis longtemps que Google a enregistré mon profil en tant qu’utilisateur et certainement aussi en tant que référenceur. On joue sur une tendance dangereuse car je suis jugé par un moteur de recherche et toute ma vie en ligne peut être impactée par cette évaluation. Chaque outil Google que j’utilise entre des données sur mon profil et il n’y a pas besoin d’être paranoïaque pour comprendre que c’est un sentiment extrêmement désagréable d’avoir un PersonRank, surtout qu’il est impossible d’y échapper. Il ne faut pas oublier que le rêve de Larry Page, fondateur de Google, est d’implanter une puce dans notre cerveau qui permettrait de penser à une requête et d’obtenir instantanément la réponse sur son mobile. Depuis que Page a émis cette idée, les ingénieurs Google ont entendu le message, mais bien extrapolé!