L’article suivant est une traduction autorisée par Adam Audette (@audette) que je remercie pour sa gentillesse et son partage qui nous informe sur quelques éléments très intéressants à propos de l’indexation sur Google.

L’article suivant est une traduction autorisée par Adam Audette (@audette) que je remercie pour sa gentillesse et son partage qui nous informe sur quelques éléments très intéressants à propos de l’indexation sur Google.

Les informations suivantes viennent d’une conférence de Joachim Kupke, employé chez Google pour la partie indexation du moteur de recherche.

Les trésors distribués par Joachim Kupke (Google) lors de la conférence SMX

Voici 9 trouvailles sur le référencement qui ressortent de la conférence SMX East qui s’est déroulée à New York en octobre. Globalement, c’était une conférence impeccable, mis à part les soucis de Wifi et autres de Javits Center le maudit. Danny Sullivan (l’organisateur de la conférence pour ceux qui vivent sous un rocher) a répété que « Javits est pourri », « accusez Javits, ne nous mettez pas ça sur le dos ». Danny, nous accusons Javits !

Cette année, parmi les absences remarquées de SMX East, il fallait compter Matt Cutts et Nathan Buggia, mais c’était un plaisir d’écouter des googlers moins connus (Maile Ohye) et des intervenants de Microsoft/Bing (Sasi Parthasarathy).

En tant que référenceur, je suis particulièrement intéressé par ce que les moteurs de recherche vont dire au sujet de paramètres techniques spécifiques comme l’indexation, le contenu dupliqué, le crawl et les redirections. Cette conférence proposait quelques sessions extraordinaires où un grand nombre d’informations étaient au centre des débats.

Il y avait aussi quelques surprises (voir ci-dessous) et une paire de nouveautés, mais en général l’information partagée par Joachim et les autres représentants des moteurs de recherche portait sur des éléments spécifiques qui pourraient paraître obscurs à quiconque en dehors du cercle des « initiés » du référencement. J’adore vraiment tous ces trucs d’initiés !

Allons-y pour les 9 trouvailles utiles pour le référencement qui sont extraites de la contribution de Joachim Kupke lors de SMX East

Présentation de Joachim Kupke sur le contenu dupliqué

Joachim fait partie de l’équipe qui s’occupe de l’indexation chez Google. Il a partagé des bribes d’informations assez primordiales au sujet de la gestion du contenu dupliqué par Google. Joachim a également partagé quelques vues depuis l’intérieur du moteur et sa façon de voir le Web et indexer les URLs. Voici les points essentiels que j’ai retenus.

1. Impressions et Clics

Joachim a répété les termes « impressions » et « clics » dans le contexte d’une URL incluse dans l’index de Google. Il a mentionné qu’une URL qui reçoit peu ou pas d’impressions sera plausiblement plus longue à mettre à jour dans l’index (pas de surprise jusque là). Cependant, une URL recevant un grand nombre d’impressions et clics (ou provenant de domaines importants et crawlés fréquemment) sera mise à jour rapidement. C’est logique et connu de tous, mais il était intéressant d’avoir une confirmation sortie de la bouche d’un ingénieur de chez Google. Ainsi, ces redirections 301 et tags noindex sur certaines pages qui ne sont pas crawlés à nouveau et mis à jour viennent définitivement du fait qu’elles ne figurent pas sur la liste prioritaire du moteur de recherche (encore une raison pour laquelle les grandes marques l’ont facile en référencement)

2. Infrastructure de gestion du contenu dupliqué

Google est censé avoir « une tonne d’infrastructure pour éliminer le contenu dupliqué », parmi laquelle il faut citer :

- Redirection

- Détection de structure récurrente d’URLs

- Le contenu de la page

- Le tag de lien canonical (si tout le reste échoue)

A noter que Google reconnaît les structures des URLS, éliminant certains paramètres comme cause de duplication (bien sûr, ils ont également parlé de l’outil d’élimination de paramètre dans les Outils Webmaster Google).

Que veux-tu dire par « le contenu de la page » ? Ceci étant la partie la plus intéressante selon moi, voici la suite…

3. Enregistrement de l’historique des URLs

Google garde une sorte de archive.org du Web avec des versions plus anciennes du contenu (pas exactement comme cela, mais vous voyez ce que je veux dire : un enregistrement de l’historique des pages Web). Cela permet de comparer la version fraichement crawlée avec une version plus ancienne. Le contenu qui change peut être soustrait des éléments qui restent invariables au sein du site. Cela peut également donner à Google la faculté de s’assurer que les éléments globaux, zones et morceaux de contenu apparaissent à l’intérieur d’un site séparément du contenu définitivement unique et mis à jour.

4 . Google + rel=canonical = Amour

Google adore le tag « canonical » des liens. Selon Joachim, c’est une grande réussite qui a vu un rythme de déploiement exponentiel sur Internet. Chez Google, on traite ce tag avec le plus grand sérieux, en suggérant son importance comme Maile Ohye nous a expliqué à l’occasion de SMX Advanced en juin. L’intérêt de ce paramètre est donc renforcé par les propos de Maile et Joachim. Cela engendre un « énorme impact » à propos des décisions de Google sur la canonicalisation : 2 fois sur 3, rel=canonical altère la décision organique. C’est assez énorme comme chiffre !

5. Les 302 suffisent comme cibles canoniques

Les redirections font des cibles canoniques correctes. Ce paramètre a été expliqué par Joachim à deux reprises. Cela comporte deux parties :

- A cause d’une méthode interne pour gérer les slashs de fermeture des URLs, Google avait besoin (et recommande à tous les développeurs d’agir de la sorte) d’un slash de fermeture sur les cibles canoniques et les liens internes. Sans le slash de fermeture, Google va ajouter un slash et mettre à jour l’URL dans l’index.

Maintenant, j’ai trouvé de multiples exemples de pages où cela ne se déroule pas de la sorte, mais Joachim était assez ferme sur le fait que c’est un problème du Web en général que Google est obligé de contourner.

- La trouvaille en la matière est que vous devriez toujours ajouter un slash de fermeture à l’URL absolue de la cible canonique. Sans le faire, Google va l’ajouter automatiquement, mais en anticipant cette action, vous allez certainement accélérer la vitesse de réponse du serveur (qui aurait un impact pour les sites de taille importante).

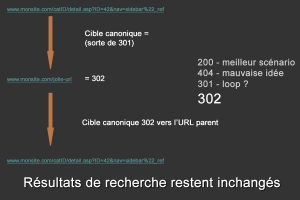

6. Comment les cibles canoniques en 302 peuvent être détournées

Les redirections 302 sont donc des cibles canoniques adéquates. Oui je sais que je me répète ! Voici la partie intéressante pour le référencement : si les 302 sont OK à utiliser dans ce cadre, je pense à une méthode pour utiliser le tag « canonical » du lien à des fins d’optimisation du référencement sans avoir à améliorer énormément la structure de l’URL. Comment cela ? Voici un exemple théorique :

Prenons, un site qui présente une structure d’URL à améliorer (voir cet exemple ) pour le référencement et des raisons d’usabilité évidentes. Cependant, les développeurs sont dans le jus, la plateforme technique est branlante, il n’y a pas assez d’argent pour un budget référencement de qualité, ou simplement les modifications ne valent peut-être pas la peine.

Un référenceur arrive avec la proposition suivante :

- Créer un tableau avec une version optimisée pour le référencement de chaque URL à améliorer.

- Ajouter ces URLs amies des moteurs dans le code source avec le tag « rel=canonical »

- Effectuer une redirection 302 depuis les URLs canoniques vers les URLs dégueulasses existantes sur le site.

- Bingo! Des jolies URLs au sein des résultats de recherche

Le tag « canonical » agit comme une redirection 301 et met à jour les indicateurs dans les résultats de recherche (comme c’est le cas). Puis la cible canonique redirige vers une 302 qui ne force pas la mise à jour (comme c’est le cas). Alors la jolie (et pseudo) URL dans le lien cible canonique va rester comme indicateur dans les résultats de recherche, pendant que la non-pseudo URL bien dégoutante va agir en tant que page temporaire aux yeux des moteurs. Pigé ? Avouez que c’est intéressant (voir le graphique basique ci-dessous pour un visuel de ce concept).

Non, je n’ai pas planifié de mettre en œuvre ceci incessamment sous peu, mais je connais au moins un site majeur d’e-commerce qui agit de la sorte (certainement de manière involontaire) et ça fonctionne parfaitement depuis le mois de juin.

7. Ne pas interdire votre contenu dupliqué ( ?)

Google dit « s’il vous plait, n’utilisez pas la directive « Disallow : » dans le Robots.txt afin d’éradiquer le contenu dupliqué ». Le contenu qui n’est pas disponible pour Google ne peut donc pas être visité et le moteur de recherche n’aime pas du tout cela. La préférence semble aller vers « mettez tout en ligne » et laissez nous décider ce qu’il y a de mieux à faire. Chaque fois qu’un contenu n’est pas disponible au crawl, les moteurs perdent la faculté de faire ce choix décisionnaire.

Ma préférence personnelle est de garder le contrôle complet, mais je comprends également leur raisonnement et la raison qui pousse à promouvoir cette méthode.

8. L’indexation peut prendre longtemps pour des URLs « impopulaires »

Joachim a expliqué qu’indexer peut prendre du temps (comme mentionné précédemment), mais c’est encore plus vrai pour des URLs obscures et peu populaires. Il faut savoir que la phase d’indexation prend du temps, mais que le nettoyage des parties existantes de l’index prend encore plus de temps. Bien entendu, il existe des manières d’initier le crawl de Google (phase séparée de la mise à jour dans l’index), mais il est indéniable que les sites moins connus ne reçoivent pas la même attention que les bons gros sites populaires.

9. Support du lien canonique au travers de différents domaines

Google va bientôt accepter le tag « canonical » sur différents noms de domaine. C’est une grande nouvelle ! Yahoo ! et Bing ont annoncé qu’ils travaillent sur la base qui est de comprendre rel=canonical.

Les autres trucs supers à SMX East

Il y avait énormément d’autres sessions extraordinaires comme David Mihm, Will Scott, Andrew Shotland, Mike Blumenthal et Mary Bowling qui ont traité des paramètres locaux liés au référencement. La régionalisation est un secteur vraiment excitant en ce moment pour les référenceurs. Cette équipe a proposé une session vraiment géniale. Tout cela m’a tellement motivé que je suis revenu avec l’intention de creuser encore plus au niveau « local ».

Article original (en anglais)